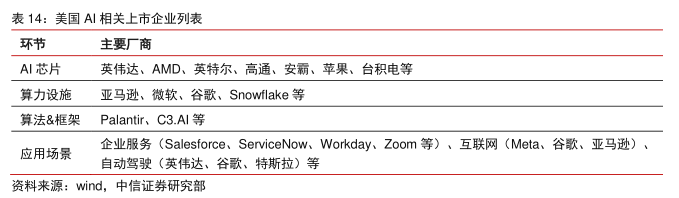

图表内容

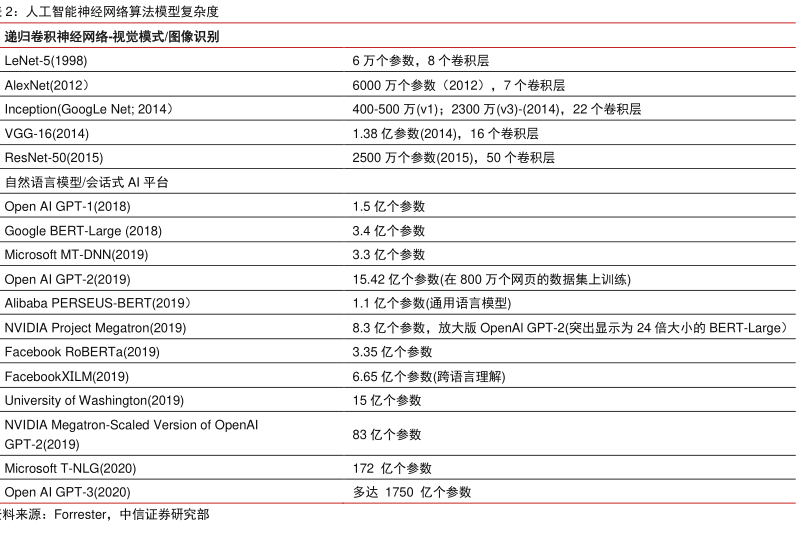

2:人工智能神经网络算法模型复杂度

递归卷积神经网络视觉模式/图像识别

LeNet-5(1998)

6万个参数,8个卷积层

AlexNet(2012)

6000万个参数(2012),7个卷积层

Inception(GoogLe Net:2014)

400-500万(w1):2300万(v3)-(2014)

22个卷积层

VGG-16(2014)

1.38亿参数(2014),16个卷积层

ResNet-50(2015)

2500万个参数(2015),50个卷积层

自然语言模型/会话式AI平台

Open Al GPT-1(2018)

1.5亿个参数

Google BERT-Large(2018)

3.4亿个参数

Microsoft MT-DNN(2019)

3.3亿个参数

Open Al GPT-2(2019)

15.42亿个参数(在800万个网页的数据集上训练)

Alibaba PERSEUS-BERT(2019)

1.1亿个参数(通用语言模型)

NVIDIA Project Megatron(2019)

8.3亿个参数,放大版OpenA1GPT-2(突出显示为24倍大小的BERT-Large)

Facebook RoBERTa(2019)

3.35亿个参数

FacebookXILM(2019)

6.65亿个参数(跨语言理解)

University of Washington(2019)

15亿个参数

NVIDIA Megatron-Scaled Version of OpenAl

83亿个参数

GPT-2(2019)

Microsoft T-NLG(2020)

172亿个参数

Open AI GPT-3(2020)

多达1750亿个参数

料来源:Forrester

中信证券研究部